Grok-3 от xAI Илонa Маска представили в понедельник, сделав громкие заявления о его возможностях и показав мощнейшую вычислительную инфраструктуру.

Основное внимание в анонсе уделили вычислительной мощности, тестам производительности и будущим функциям. Однако многие демонстрации выглядели скорее повторением того, что уже показывали другие компании в сфере ИИ.

Главной звездой презентации стал даже не сам Grok-3, а «Colossus» — гигантский кластер из 200 000 графических процессоров, который используется для обучения ИИ.

Создание этой системы проходило в два этапа: сначала провели 122 дня синхронного обучения на 100 000 GPU, затем ещё 92 дня масштабирования до полного объёма в 200 000 графических процессоров. По словам разработчиков xAI, построить эту инфраструктуру оказалось сложнее, чем саму нейросеть.

Компания уже планирует создать ещё более мощный кластер. По словам Маска, цель — увеличить текущие мощности в пять раз, что сделает этот суперкомпьютер самым мощным кластером GPU в мире.

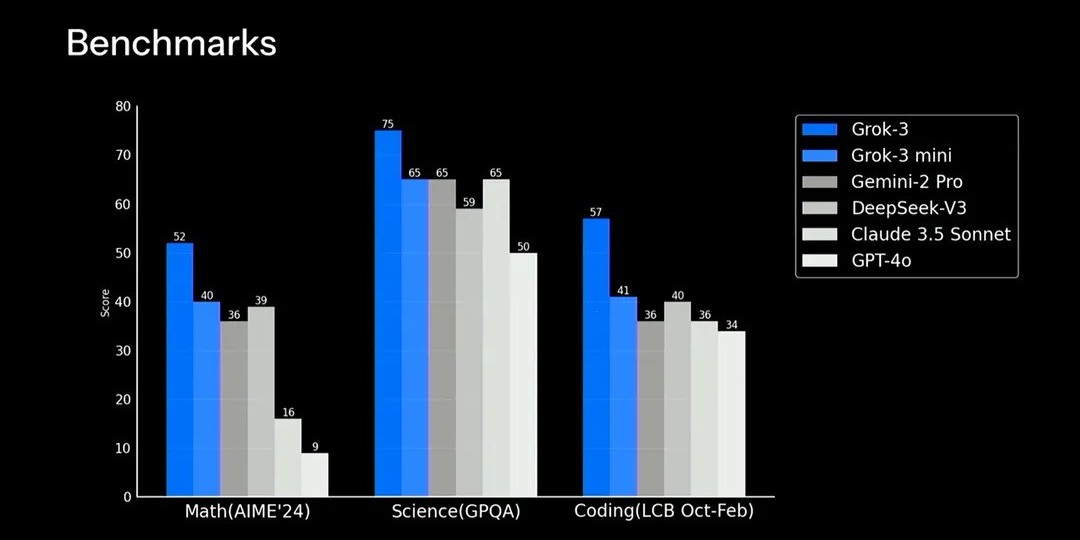

Производительность моделей на базовых тестах. Источник: xAI

Что касается производительности, Grok-3 демонстрирует впечатляющие результаты в стандартных тестах для ИИ. Базовая версия модели (без встроенных механизмов Chain of Thought и логического рассуждения) стабильно занимает топовые позиции в тестах по математике (AIME), науке (GPOA) и программированию (LCB).

Кроме того, Grok-3 показывает сильные результаты в слепых тестах, что подтверждает его потенциал.

Grok-3 прошёл анонимное тестирование

xAI подтвердили, что загадочная модель с кодовым названием «Chocolate» на самом деле была тестовой версией Grok-3, загруженной в LLM Arena.

Во время испытаний она показала лучший рейтинг ELO среди всех языковых моделей. Это означает, что пользователи чаще выбирали её ответы, даже не зная, какая именно нейросеть их генерировала. Grok-3 сумела обойти конкурентов в условиях анонимного тестирования.

Такая методика считается одним из самых точных способов оценки качества моделей. В отличие от стандартных тестов, где ИИ может подгонять результаты, обучаясь на тех же датасетах, здесь всё основано исключительно на пользовательских предпочтениях и слепом выборе тысяч тестировщиков.

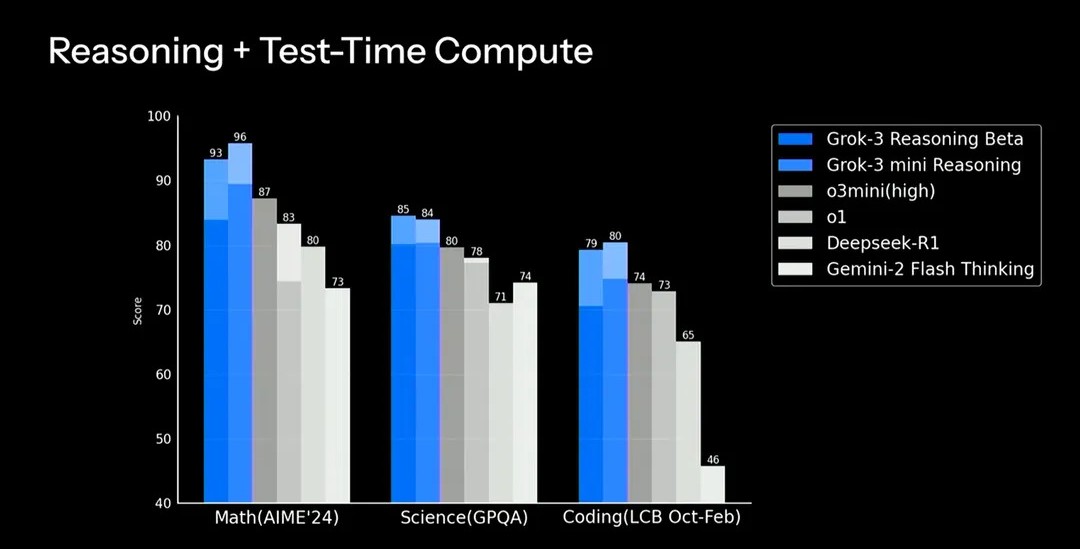

Результаты вычислений одновременно с логическим размышлением. Источник: xAI

Специальная версия Grok-3 под названием «Reasoning Beta» использует внутреннюю цепочку рассуждений и дополнительные вычисления во время тестирования. Это позволило модели достичь рекордных 93% на математическом тесте AIME 2025, тогда как другие лидирующие модели пока не поднимаются выше 87%.

Любопытно, что уменьшенная версия, Grok-3 Mini Reasoning Beta, иногда показывает даже лучшие результаты, чем версия поновее. Это объясняется более длительным периодом обучения.

Другими словами, у полноразмерного Grok-3 ещё есть потенциал для роста, и если он получит столько же тренировочного времени, сколько его компактная версия, результаты могут стать ещё лучше. Больший объём параметров даёт модели хороший запас прочности.

Однако, когда xAI попыталась продемонстрировать возможности Grok-3 вживую, презентация больше походила на догоняющую игру, чем на прорыв. Разработчики показали, как нейросеть решает задачи по физике и пишет код для игр с нуля — впечатляюще, но ChatGPT, Claude и Gemini умеют делать это уже давно.

Такая же технология, но с новыми инструментами

xAI также представила DeepSearch — исследовательского агента, который, как и аналогичные инструменты от OpenAI и Google, анализирует веб-ресурсы и создаёт развернутые отчёты по заданным темам.

Пользователи X Premium Plus уже получили доступ к Grok-3, но его наиболее мощная версия и будущие обновления будут доступны либо в отдельном приложении, либо на Grok.com.

Голосовое взаимодействие, похожее на «Advanced Voice Mode» от OpenAI, появится в ближайшие недели. Маск отметил, что это не просто озвучка текста, а полноценная AI-голосовая модель, способная на естественную и выразительную речь.

Разработчикам откроют доступ к API и функции аудиотранскрипции, что сделает Grok-3 мощным инструментом для приложений на базе искусственного интеллекта.

После демонстрации того, как Grok создаёт игру в стиле Tetris, команда xAI анонсировала AI гейминг-студию — платформу, которая позволит разработчикам создавать игры, используя Grok-3.

Сейчас модель запускается постепенно, и пока не все получили к ней доступ. Однако первые тестеры уже успели попробовать её, и их отзывы в основном положительные.

Что думают тестировщики?

Известный специалист в области ИИ Лекс Фридман написал в Х:

«Мне удалось подробно протестировать Grok-3 на раннем доступе. Это действительно впечатляющая модель. Поздравляю Илона и команду с отличной работой.»

Бывший сооснователь OpenAI Андрей Карпати сравнил Grok-3 с ведущими ИИ-моделями:

«Grok-3 + думает примерно на уровне самых передовых моделей OpenAI (o1-pro, $200 в месяц) и немного превосходит DeepSeek-R1 и Gemini 2.0 Flash Thinking. Поздравляю команду xAI, у них явно огромная скорость развития.»

Пользователь X Penny2x опубликовал платформер в стиле Mario Bros, который он создал с помощью Grok-3. Он отметил, что модель не только понимает запросы, но и улучшает игру с каждой новой версией.

«Я просто прошу внести изменения, и он снова выдаёт мне игру в одном файле, который можно сразу запустить на компьютере. Это невероятно. Мы уже живём в будущем — теперь каждый может стать разработчиком», — написал он.

Сыграть в созданную с помощью Grok-3 игру можно на Thank Doge.

Компания xAI также подтвердила планы открыть исходный код Grok-2, когда Grok-3 окончательно стабилизируется. В прошлом xAI уже выкладывала старые версии своих моделей, чтобы поддерживать развитие отрасли, хотя Grok-2 заметно уступает лучшим решениям на рынке.

На данный момент Grok-3 показывает уровень, сопоставимый с топовыми ИИ-моделями. Однако настоящая проверка начнётся, когда xAI добавит обещанные голосовые функции, инструменты для геймдева и API-доступ. Теперь очередь за OpenAI, которая скоро представит GPT-4.5.